Dauernd auf der Suche nach guten Usability Test Tools sind wir auf einen spannenden Service von Userlutions gestoßen. Der Service bietet webbasierte schnelle und günstige Usability-Tests an. Hier kann man z.B. für nur 294 Euro mit 7 Probanden einen 15‒20 minütigen unmoderierten Remote-Usability-Test durchführen. Die Ergebnisse werden laut Webseite innerhalb von 24 Stunden in Form von Bildschirm- und Tonaufnahmen geliefert. Sogar mit einer 100%-Zufriedenheitsgarantie wird der Rapid User Test beworben. Ist der Auftraggeber mit den Testergebnissen nicht zufrieden, z.B. wenn ein Proband nicht überzeugt, gibt es kostenlos einen weiteren Probanden. An sich ist das eine super Sache: alle Ergebnisse innerhalb von 24 Stunden, geringe Vorbereitung, kein Aufwand in der Durchführung. Einzig bei der Aufgabenerstellung und der Auswertung ist man noch selber gefragt.

Um die Qualität des Services für uns selber einschätzen zu können, haben wir uns drei kleine Aufgaben zur Webseite https://www.free-hidrive.com/ überlegt, die wir den Probanden in einem laborgestützten Inhouse Usability Test und im Rapid User Test gestellt haben. Natürlich ist dies kein wissenschaftlich fundierter Methodenvergleich gewesen. Wir haben hiermit folgende Ziele verfolgt:

- In welchem Rahmen können wir den Rapid User Test sinnvoll bei uns einsetzen?

- Welche Vor- und Nachteile hat der Rapid User Test im Vergleich zum Inhouse Test?

- Wie ist die Qualität der Testergebnisse des Rapid User Tests?

In den folgenden Abschnitten stelle ich euch nun unsere Erfahrungen mit dem Rapid User Test sowie einen kleinen aber natürlich nicht repräsentativen Vergleich mit dem laborgestützten Usability Test vor.

- Die Erstellung eines Rapid User Tests

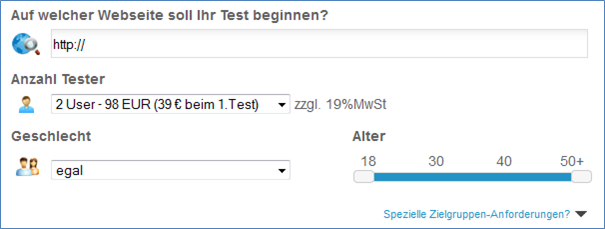

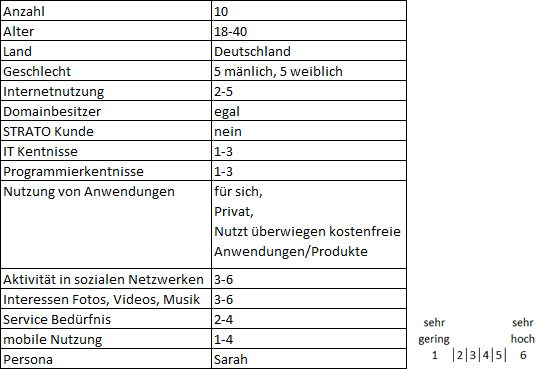

Die Erstellung eines Rapid User Tests ist denkbar einfach (siehe Abbildung 1). Hier werden verschiedene Variablen wie URL der Webseite, Anzahl der Probanden, Geschlecht und Alter abgefragt. Da wir für unseren Usability Test an die Testpersonen weitere spezielle Anforderungen hatten wie z.B. Internetnutzungshäufigkeit oder Mediennutzungsverhalten haben wir das zusätzliche Freitextfeld „Spezielle Zielgruppen-Anforderung“ verwendet. Leider haben wir hier versäumt, die Qualität der Probanden im Nachgang des Rapid User Test per Online Fragebogen zu überprüfen. Daher können wir über die Qualität der Probanden keine genaue Aussage treffen. Tabelle 1 zeigt das Probanden-Briefing. In unseren Inhouse Tests überprüfen wir jetzt vermehrt die Qualität der von der Agentur gelieferten Probanden.

Anschließend kommt der wesentlich schwierigere Bereich: die Beschreibung der Aufgabenstellung. Da man im Gegensatz zum laborgestützten Usability-Test während der Untersuchung nicht mit dem Probanden kommunizieren kann, müssen die Aufgabenstellungen sehr genau beschrieben werden. „Userlutions“ bietet hierfür Unterstützung in Form von Beispieltexten.

Für den durchzuführenden Test hatten wir uns auf folgende drei Aufgabenbereiche geeinigt:

- Exploration und Information über free-hidrive

- Informieren über Pakete mit mehr Speicher

- Auffinden des Feedbackbuttons

Abschließend kann man den Probanden noch konkrete Fragen stellen die nach Beendigung des Rapid Usability Tests eingeblendet werden. Da wir Rogator als Umfrage Tool einsetzen, haben wir hier lediglich den entsprechenden Umfrage-Link eingefügt.

Je nach Komplexität der Aufgabenstellung und Erfahrung des Testerstellers muss man mit 30 bis 60 Minuten zur Konzeption des kompletten Rapid User Tests einplanen. Im Vergleich zum laborgestützten Inhouse Usability Test geht dies doch recht schnell.

- Auswertung und Besonderheiten beim Rapid User Test

Innerhalb von 48h lagen alle Ergebnisse vor. Es wurde also etwas mehr Zeit benötigt, was jedoch durch unsere speziellen Probandenanforderungen zu begründen ist. „Userlutions“ hatte mich extra angerufen und um ein ok für diese Verzögerung gebeten. Man muss allerdings nicht 24 h bzw. in unserem Fall 48 h warten, um die Testergebnisse auszuwerten. Sobald ein Proband den Test abgeschlossen hat, kann man sich die Ergebnisse über das Online-Tool ansehen. Zusätzlich bietet die Online-Oberfläche einige interessante Features zur Unterstützung der Auswertung.

Folgende Punkte fallen im Vergleich mit dem Inhouse Usability Test auf:

- Anzahl der Probanden, bei denen ein Usability-Problem aufgetreten ist, war im Rapid User Test wesentlich geringer:

Sowohl beim Inhouse Usability Test als auch beim Rapid User Test wurden im Großen und Ganzen die gleichen Findings ermittelt. Jedoch war die Anzahl der Probanden, die Probleme hatten je Finding, beim Rapid User Test geringer. So ist z.B. das folgende Usability-Problem im Inhouse Usability Test bei 7 Probanden aufgetreten und beim Rapid User Test bei 4 Probanden.„Probanden hatten Schwierigkeiten, die angebotenen Produkte miteinander zu vergleichen. Die Probanden erwarteten eine Feature-Vergleichstabelle.“

- Interviewer kann den Proband nicht unterbrechen oder bei falschem Verständnis der Aufgabenstellung Hilfestellung geben:

So hatte z.B. ein Proband einen falschen Link angezeigt bekommen und konnte daher nicht an der Untersuchung teilnehmen. Weitere Schwierigkeiten sind beim Lesen der Aufgabenstellungen entstanden. Mehrere Probanden überflogen lediglich die Aufgabenstellung was dazu führte, dass 2 Probanden die Aufgabenstellung falsch verstanden. Ein Proband verwendete sehr häufig Hotkeys, was es zwischenzeitlich sehr schwer machte, seinen Aktionen genau zu folgen.

- Keine einheitlichen technische Rahmenbedingungen der einzelnen Tests:

Es hat einerseits viele Vorteile, wenn der Proband die Aufgabenstellungen in seiner gewohnten Umgebung mit dem gewohnten Browser und der gewohnten Auflösung und nicht in einer sterilen Testumgebung bearbeitet. Andererseits jedoch ist es nachteilig, dass die technischen Rahmenbedingungen so nicht standardisiert werden können. So haben wir im Inhouse Test ein Usability-Problem nur entdeckt, da wir eine Standardauflösung einstellten (die von den meisten Kunden genutzte Auflösung). Nach drei Testdurchgängen im Inhouse Test ist uns aufgefallen, dass kein Proband auf der Startseite scrollte. Für die Probanden war es trotz Scrollbar nicht ersichtlich, dass die Startseite noch mehr Informationen darstellt. Dies ist darauf zurückzuführen, dass der sichtbare Bereich in der Standardauflösung direkt unter den dargestellten Bildern endete. Somit war es für die Probanden nur anhand des Scrollbalkens, nicht jedoch anhand der Seite an sich ersichtlich, dass die Webseite noch mehr Informationen abbildete. Nachdem wir die Auflösung etwas angepasst hatten, scrollten die Probanden auch auf der Startseite. Auf der Grundlage des Findings haben wir den Abstand zwischen Texten und Bildern reduziert, um das beschriebene Problem zu vermeiden.

- Fazit

Insgesamt macht aus unserer Sicht der Rapid User Test einen sehr guten Eindruck. Die Erstellung des Tests war sehr einfach und die Findings waren mit unserem Inhouse Test durchaus vergleichbar. Wichtig hierbei ist, dass man darauf achtet, die Aufgabenstellung sehr einfach und genau zu beschreiben. Auch sollte der Prototyp absolut selbsterklärend sein und kein spezielles Wissen voraussetzen, da man als Interviewer keinerlei Feedback während des Tests geben kann. Wir planen demnächst einen Rapid User Test mit einer sehr speziellen Zielgruppe und einer Webseite die durchaus einiges an Vorwissen benötigt. Wir sind gespannt, inwieweit der Rapid User Test auch hier gute Ergebnisse liefert.

Da wir mit einer fertigen Webseite getestet hatten, fragen wir uns auch, ob ein absolut ungestalteter Prototyp per Rapid User Test auf Bedienbarkeit überprüft werden kann. Im Inhouse Test ist es einigen Probanden sehr schwer gefallen, mit solchen Prototypen zu arbeiten, und sie waren sehr stark auf Unterstützung des Interviewers angewiesen. Es ist also offen, inwieweit der Rapid User Test für solche Fälle geeignet ist. Auch dies werden wir in nächster Zeit testen.

Weiterführende Links:

Aktuelle Untersuchung von eresult

Benjamin Uebel im Experteninterview (Geschäftsführer Userlution)

Webseite von Usersolution

Unmoderierte Remote Usability Tests – Sicht der Anbieter

2 Gedanken zu „Inhouse Usability Test vs. unmoderierter Remote Usability Test“